ChatGPT運用了哪些高端技術?

ChatGPT整體技術方案是基于 GPT-3.5 大規模語言模型通過人工反饋強化學習來微調模型,讓模型一方面學習人的指令,另一方面學習回答的好不好。

核心提升了什么?

ChatGPT在對話場景核心提升了以下三方面:

1)更好的理解用戶的提問,提升模型和人類意圖的一致性,同時具備連續多輪對話能力。

2)大幅提升結果的準確性,主要表現在回答的更加的全面,同時可以承認錯誤、發現無法回答的問題。

3)具備識別非法和偏見的機制,針對不合理提問提示并拒絕回答。

ChatGPT的提升主要涉及以下三方面技術:

1)性能強大的預訓練語言模型GPT3.5,使得模型具備了博學的基礎。

2)webGPT等工作驗證了監督學習信號可大幅提升模型準確性。

3)InstructGPT等工作引入強化學習驗證了對齊模型和用戶意圖的能力。

整體技術流程

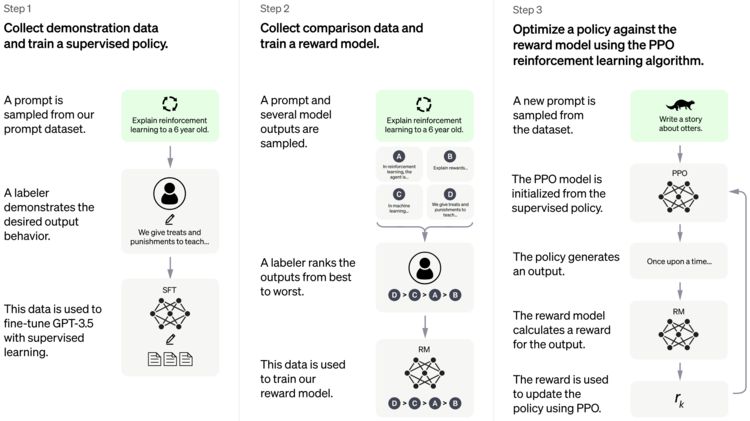

ChatGPT的訓練過程分為微調GPT3.5模型、訓練回報模型、強化學習來增強微調模型三步:

第一步:微調GPT3.5模型。讓GPT 3.5在對話場景初步具備理解人類的的意圖,從用戶的prompt集合中采樣,人工標注prompt對應的答案,然后將標注好的prompt和對應的答案去Fine-tune GPT3.5,經過微調的模型具備了一定理解人類意圖的能力。

第二步:訓練回報模型。第一步微調的模型顯然不夠好,至少他不知道自己答的好不好,這一步通過人工標注數據訓練一個回報模型,讓回報模型來幫助評估回答的好不好。具體做法是采樣用戶提交的prompt,先通過第一步微調的模型生成n個不同的答案,比如A、B、C、D。接下來人工對A、B、C、D按照相關性、有害性等標準標準并進行綜合打分。有了這個人工標準數據,采取pair-wise 損失函數來訓練回報模型RM。這一步實現了模型判別答案的好壞。

第三步:強化學習來增強微調模型。使用第一步微調GPT3.5模型初始化PPO模型,采樣一批和前面用戶提交prompt不同的集合,使用PPO模型生成答案,使用第二步回報模型對答案打分。通過產生的策略梯度去更新PPO模型。這一步利用強化學習來鼓勵PPO模型生成更符合RM模型判別高質量的答案。

通過第二和第三步的迭代訓練并相互促進,使得PPO模型能力越來越強。

主要涉及的技術細節

1) GPT3.5理解能力提升

ChatGPT是在GPT3.5模型技術上進行微調的,這里對GPT-3.5在GPT3基礎上做的工作進行梳理,官方列舉了以下GPT-3.5系列幾個型號:

code-davinci-002 是一個基礎模型,對于純代碼補全任務。這也是ChatGPT具備超強代碼生成能力的原因。

text-davinci-002 是在code-davinci-002基礎上訓練的InstructGPT模型,訓練策略是instructGPT+FeedRM。

text-davinci-003 是基于text-davinci-002模型的增強版本,訓練策略是instructGPT+PPO。

根據如下圖官方發布的模型時間線和文檔,我們可以了解到ChatGPT是在text-davinci-003 基礎上微調而來,這也是ChatGPT模型性能如此強大的核心要素。因為GPT-3.5系列模型是在2021年第四季度之前的文本和代碼樣本上訓練,所以我們體驗ChatGPT時候同樣無法回答訓練樣本日期之后的問題。

2) 監督信號提升效果顯著

GPT3之前在預訓練+微調已經是NLP任務中標準范式,GPT3模型的訓練是純自監督學習并以API的形式發布,用戶不具備微調的能力,官方也是主打預訓練+提示學習的能力。Prompt方法本質是挖掘語言模型本身具備的知識,恰當的提示去激發語言模型的補全能力。監督信號微調可以理解為改變了語言模型的理解能力,InstructGPT的工作可以理解為對GPT3-SFT做了數據增強提升,使得模型在理解人類指令方面更出色。但這并不影響監督信號對最終效果的價值。

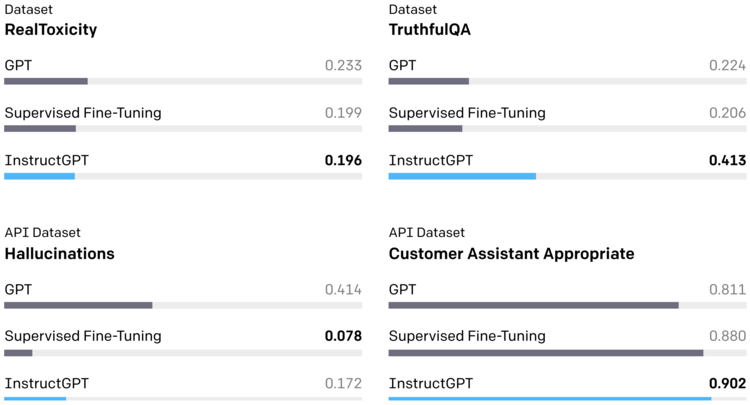

在InstructGPT的工作中,我們可以看到GPT3-SFT和InstructGPT在毒性、幻覺、理解客戶能力上,監督學習微調已經和強化學習對比有很大的競爭力,甚至在幻覺角度比基于強化學習的InstructGPT提升很明顯。

3) 人類反饋強化微調效果

ChatGPT通過人類反饋強化學習(RLHF)來讓模型理解人類的指令。人類反饋強化學習(RLHF)是DeepMind早期提出的,使用少量的人類反饋來解決現代RL任務。RLHF的思想在很多工作中都有體現,例如OpenAI的webGPT、DeepMind中Sparrow等都通過人類的反饋進一步提升大模型的效果。

RLHF整個訓練過程如下圖所示:

目標是實現后空翻的任務,智能體Agent在環境中隨機行動,每隔一段時間,兩個行為的視頻片段給一個人,人判斷兩個視頻哪個更接近目標。通過人的反饋數據,學習一個最能解釋人類判斷的獎勵模型Reward Model,然后使用RL來學習如何實現目標。隨著人類繼續提供模型無法判斷時候的反饋,實現了進一步完善它對目標的理解。智能體Agent從人類反饋中學習最終在許多環境中有時甚至是超過人類的表現。

行動驅動的大語言模型

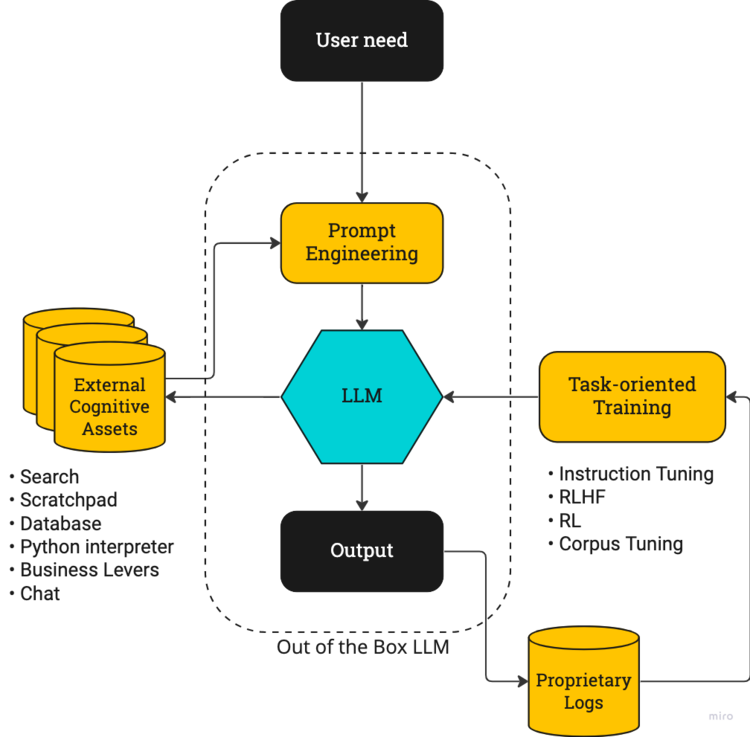

盡管學術界一直無法真正定義AGI,今年大型語言模型(LLM)的表現讓我們對通用人工智能有了期待,通過OpenAI的ChatGPT、Google的PaLM、DeepMind的Sparrow取得的成功,人工智能的未來應該是行動驅動的,一個行動驅動的LLM看起來很像AGI,如下圖所示:

模型的行為就像一個智能體Agent選擇行動。在中間,我們有開箱即用的基礎模型LLM。用戶通過Prompt詢問模型結果。

左邊是外部可利用的資源,這些可以是任何將文本作為輸入并提供文本作為輸出的函數,包括搜索、數據庫、代碼解釋器和與人聊天等,它可以增強模型的能力。

右邊是我們有任務導向的訓練,如instruction tuning、RLHF等。instruction tuning相對好實現,RLHF需要調整PPO算法相對較難。整體上RL利用使用日志等專有數據,通過創建強大的反饋回路,訓練模型使其更加符合任務需求并迭代優化。

本文標題: ChatGPT運用了哪些高端技術?

本文地址: http://3824dh.com/brand/news-881aaf7b5.html

內容均來源于網絡,錯誤糾正或刪除請發郵件,收件郵箱kefu@huangye88.com

最新推薦資訊

熱門推薦

熱門推薦企業

2009-2025 黃頁88版權所有 京ICP備2023012932號-1 │ 京公網安備 11010802023561號 京ICP證100626

內容均來源于網絡,錯誤糾正或刪除請發郵件,收件郵箱kefu@huangye88.com